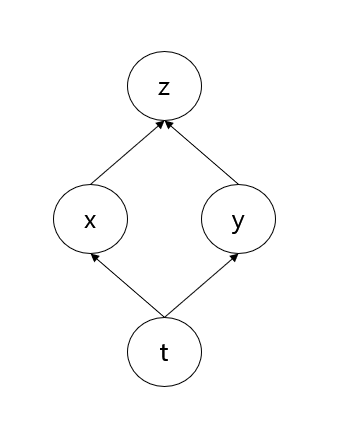

이변수 함수 $z = f(x, y)$ 에 대해, $x = g(t), y = h(t)$ 이고

$f(x, y), g(t), h(t)$ 가 미분 가능한 함수이면

${dz \over dt} = {\partial z \over \partial x}{dx \over dt} + {\partial z \over \partial y}{dy \over dt}$

이라는 것이 이변수 함수의 chain rule 입니다.

따라서 위와 같은 신경망에서 z 에 대한 t의 편미분 값을 back propagation 알고리즘을 통해 얻을 수 있는 것입니다.

이를 확장하면 아무리 복잡한 신경망이라도 각 과정이 미분 가능한 함수들로 구성되어 있다면 back propagation 알고리즘이 잘 동작하는 것을 알 수 있습니다.

Weight Sharing 을 할 때 back propagation 이 어떻게 되는건지 갑자기 햇갈려서 저처럼 햇갈리실 분들을 위해 정리해 보았습니다.